Jövőbe tekintő sorozat 10. rész: NVidia GeForce 8800GTX teszt

- Írta: fojesz

- 2006. december 10.

Link másolása

Megérkezett szerkesztőségünkbe a nyugaton november első hetében bemutatkozott új GeForce, a 8800 GTX, melynek legfőbb érdekessége, hogy az első olyan videokártya, mely az újonnan kifejlesztett G80 elnevezésű grafikus processzor és a DirectX 10 hathatós támogatásával domboríthat egy hatalmasat.

Miután az ATI útjának indította az X1000-es kártyákat, a cég által szerzett előny egyértelmű és biztos volt riválisával szemben. A széria eljövetelével nem csupán új királyt avathattunk a Radeon X1950XT személyében, de egy vadi új oldaláról ismerhettük meg a grafikus megjelenítést, miután az új kártyák jelentősen átalakított pixel shader egységekkel és memóriavezérlővel hivalkodhattak. Az Nvidiának lépnie kellett tehát, a 2002 óta fejlesztett G80-ba apait-anyait bele kellett adnia, ha utol akarta érni és túlszárnyalni az aktuálisan csúcs ATI-kártyák által nyújtott teljesítményt.

A G80 fejlesztésénél a hangsúly kétségtelenül a minél nagyobb kihasználtságra helyeződött, vagyis a készítők úgy tervezték meg az új processzort, hogy az mindig kihasználja az erőforrásokat, annak minden része együttesen, egyaránt dolgozzon – korábbi GPU-knál fordult elő, hogy míg például egyes shaderek kőkeményen dolgoztak, addig mások „pihentek" függően a megjelenített alkalmazástól. Az Nvidia által unified shader néven emlegetett architektúra lényegét dióhéjban a fentiekkel lehetne összefoglalni. Konkrétabban arról van szó, hogy a chipben nincsenek különálló vertex illetve pixel shaderek, hanem egységes stream processzorok vannak, melyek az előbbiek által végzett műveleteket is végre tudják hajtani. Lévén a végrehajtandó feladatok tömkelege a stream processzorokra együttesen hárul, mindennemű veszteség megszűnik gyakorlatilag. A chip 128 darab stream processzort tartalmaz, ezek 1350Mhz-en ketyegnek, összesen teljesítményük körülbelül 520 gigaflops. Úgy vélem, nekünk, játékosoknak felesleges ecsetelni, hogy mennyire komoly lehetőségekkel bír az új G80 néhány mostani és későbbi combos gépigényű játék szempontjából. Maga a GPU egyébként 575Mhz-en szalad, 681 millió tranzisztorból épül fel és 400 mm2 méretű, csíkszélessége pedig 90 nanométer. Érdekességként jegyezzük meg, hogy az Nvidia eddigi legjobbja, a G71 278 millió tranzisztorból épült fel csupán. Memóriatéren is erős a G80: a memória busz maga 384 bit, ez hat darab 64 bites csatornát jelent. A crossbar memóriavezérlőhöz 768Mb 900Mhz-es (valójában 1800Mhz) memória csatlakozik 86,4Gbps sávszélességgel.

Az Nvidia mérnökei a képminőségre is rágyúrtak a teljesítmény fokozása mellett, sikerült utolérni az ATI-t ezúton is. Elérhetővé vált az úgy nevezett Coverage Sampling Anti-Aliasing (CSAA), mely biztosítja azt, hogy a kártya felvehesse a kesztyűt élsimítás terén az ATI üdvöskéi ellen – mint tesztjeink során kiderült, a G80 állta a próbát, s mind képminőség, mind pediglen gyorsaság szempontjából olyat produkált, amilyet a legújabb Radeonok sem tudtak. További érdekesség, hogy a mostanság oly népszerű HDR (High Dynamic Range) grafikai opció bekapcsolható Anti-Aliasing mellett is, mely révén szemeinknek még nagyobb vizuális orgazmusban lesz része. Az anizotropikus szűrések terén is bizonyított anno az ATI, azonban az Nvidia-pártiaknak sem kell mostantól aggódniuk: a G80 ugyanis nem csupán beérte az újabb Radeonok által nyújtott fícsöröket itt is, de még rá is pakolt némi lóerőt azokra. A DirectX 10 a Windows Vista megvásárlása után elérhető ugyan, de kell is alá némi vas, hogy a benne rejlő lehetőségeket megfelelően kihasználhassuk – örömmel jelenthetjük, a G80-nal felszerelt GeForce 8800 az első olyan videokártya, mely támogatja is az új rendszert és tud is alá elég erőt biztosítani, hogy az komolyabban működhessen (természetesen nem kötelező majd egy 8800-erősségű kártya a használatához). Bár az első DirectX 10-es játékokra (például Crysis – megjelenés jövő év áprilisa után) még várni kell, addig is nem árt kielemezni miről is van szó lényegében. Gyakorlatilag teljesen újraírták a rendszert a Microsoftnál, ily módon például az overhead (adatátvitel miatti késleltetés) csökkenni fog. A távoljövőben csak azok a videokártyák támogatják majd a DirectX 10-et, melyek a már említett unified shader architektúrára épülnek. Megjelennek majd az úgy nevezett geometriai shaderek is, melyeknek a főprocesszor tehermentesítésében lesz nagy szerepük.

Ideje foglalkozni magának a kártyának a méreteivel is. Gondolom, mindent elárulok azzal, ha azt mondom: jelenleg a piacon nincs hatalmasabb kártya a GeForce 8800-nál. Hihetetlenül hosszú darabbal van dolgunk, melynek magassága is szemrevaló a szintén nagy ventilátor miatt. Daks kollégával hatalmasakat csodálkoztunk a kártya méretén, hiszen egy ekkora vas éppen belefért pár éves gépházunkba (kettőt-hármat rávertünk kalapáccsal – végül csak belepasszíroztuk :)). Tesztgépünket az Intel "Bad Axe 2" D975XBX2 típusú adatlapjára építettük, melybe a nemrégen megjelent négymagos Intel Core 2 Quad processzorok egyikét helyeztük 2*512 megabájt DDR2-es RAM társaságában. Az Nvidia GeForce 8800 GTX teljesítményét az ATI Radeon X1900XTX-ével hasonlítottuk össze, ami 512 megabájt memóriával van felszerelve. Az áramot egy jó minőségű, 550W-os táp szolgáltatta, hiszen új kártyánk annyit eszik, mint egy disznó – a GeForce 8800 kétszer annyi energiát kölcsönzött a tápegységen keresztül, mint a vízhűtéses ATI-csúcsmodell. A merevlemezre feltelepített Windows XP-nket csupán néhány driverrel, segédprogrammal és a tesztjátékokkal terheltük. Ezen címek egy részét magunk jelöltük ki, egy-kettőt pedig Ti választhattok meg: ezek többnyire új, felső kategóriás gépeket igénylő gammák, melyeket a legújabb motorok hajtanak – többek között megpróbálkoztunk az Unreal 3.0 Engine egy előfutárával is az érdekesség kedvéért. Lássuk hát, hogy milyen következtetéseket vontunk le a mérések után!

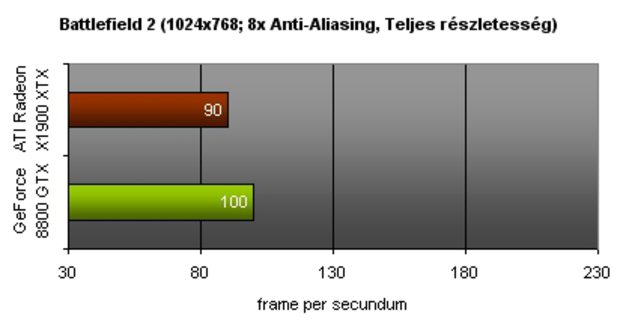

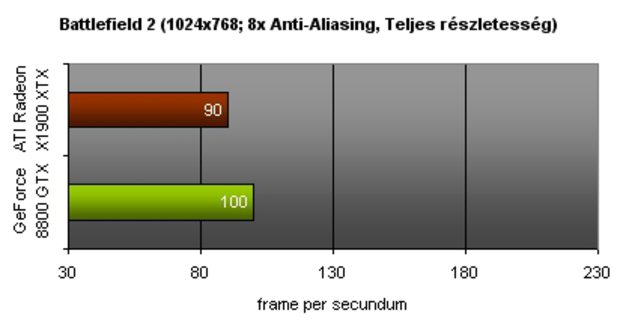

Battlefield 2 (1024x768; 8x Anti-Aliasing)

A sort az Electronic Arts tavaly nyári lövöldözős játékával nyitottuk. Biztosan sokatokban merült fel a kérdés, hogy miért nem az újonnan megjelent Battlefield 2142-n keresztül izzasztottuk le a kártyát: ennek viszonylag egyszerű oka, miután szerkesztőségünkbe még a kártya tesztelésekor nem érkezett meg a legújabb rész tesztverziója. Sebaj! Gondoltuk a srácokkal, s ezzel a lendülettel fogtuk a Battlefield 2 telepítőlemezét, majd felpakoltuk gépünkre a szintén gépigényes produktumot. A GeForce 8800 segítségével stabil 100 fps-t értünk el úgy, hogy eközben a legnagyobb pályákon játszottunk elképesztően sok játékos társaságában. Ugyanilyen helyzetben átlag 90 fps-t mértünk az ATI-kártya esetében: bár itt is sikerült elérni időnként a százas határt, azonban gyakran visszaesett a számláló, mely átlagolva gyengébb teljesítményt jelent.

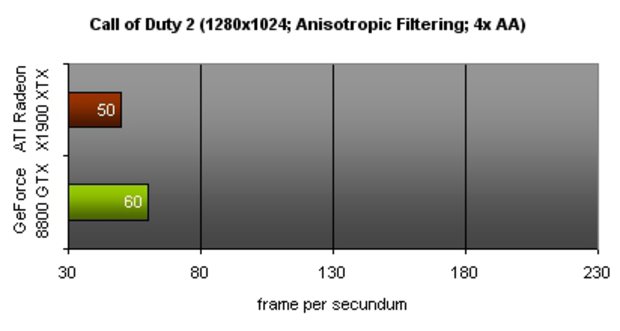

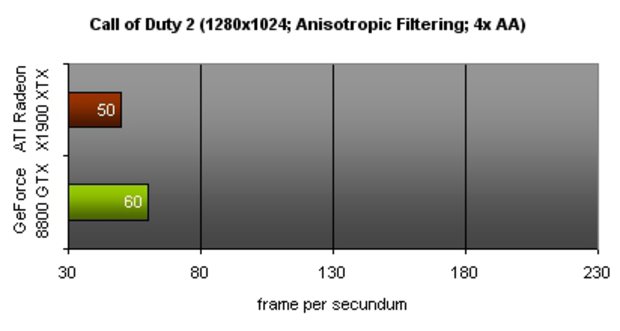

Call of Duty 2 (1280x1024; Anisotropic Filtering; 4x Anti-Aliasing)

A piacon talán jelenleg a Call of Duty 2 a leggépigényesebb világháborús FPS – legalábbis a Medal of Honor: Airborne és a Brothers in Arms: Hell's Highway megjelenéséig biztosan. Az Infinity Ward lövöldözős címe azért is érdekelt minket, mert Nvidia által támogatott játékról van szó: kíváncsiak voltunk tehát, hogy vajh mennyit számít az, ha egyes hardvercégek odabiggyeszttetik emblémájukat egy-egy játék dobozára. A GeForce-kártya mérésekor 60 fps-t kaptunk eredményül, míg a Radeon 50 fps-en vizsgázott. A húsz százalékos teljesítménykülönbség azonban csak a kártyákra fogható, méréseredményeink nem függhettek a Nvidia-reklámtól, ily módon nem érdemes hinni az efféle marketingnek.

Dark Messiah of M&M (1280x1024; 16x AF; 8x Anti-Aliasing)

Az Arkane Studios által fejlesztett akció-szerepjáték nevezhető akár a lehetőségek játékának is: szinte minden létező effektet bekapcsolhatunk benne, az eredmény pedig bámulatos – a továbbfejlesztett Source engine elképesztő minőségben nyilvánul meg. A GeForce 8800 GTX 60 fps-en futtatta a játékot, míg a Radon X1900XTX átlag 45 fps-en: elérte ugyan a hatvanas számot ő is, mi azonban átlagot számoltunk, mely jóval alacsonyabb teljesítményt jelent. Érdekesség, hogy bár a Dark Messiah of Might & Magic Nvidia által támogatott a játék, ennek ellenére a G80-nal felépített konfiguráción időnként rövid időkre csúnyán beröccent - ilyet az ATI-kártyával történő tesztelés során nem tapasztaltunk.

F.E.A.R. (1024x768)

A nemrégen kiegészült F.E.A.R. szintén megkövetelte magának az erős gépet, tavalyi megjelenésekor ámultunk mind a cím grafikáján, mind a rendszerigényén: horrorjáték lévén, a F.E.A.R. igazán fény- és árnyékeffektek terén erős, hiszen egy efféle játéknál nincs is fontosabb hangulati elem a félhomálynál, a sötétségnél és a sejtelmes fényforrásoknál. Az Nvidia által támogatott F.E.A.R. 60 fps-en teljesített az Nvidia-kártyával, míg az ATI-csúcsmodell 45 fps-t ért el. Valószínűleg a mi készülékünkben volt a hiba, de mindkét kártyával időnként nagyon csúnyán beszaggatott a játék, ami miatt olykor játszhatatlanná is vált a Monolith lövöldözőse: nem igazán tudtuk el eldönteni, hogy vajon mi tett keresztbe a tesztelésnek a kártyákon kívül – a négymagos processzor vagy az egy gigányi RAM? :)

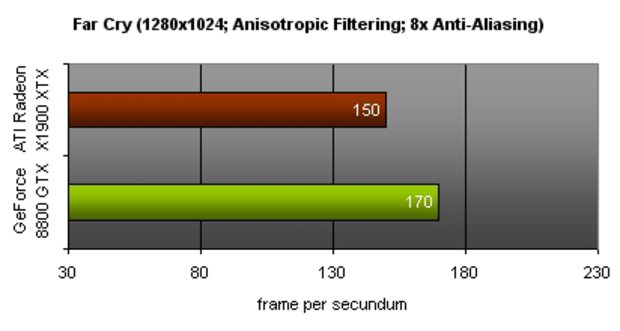

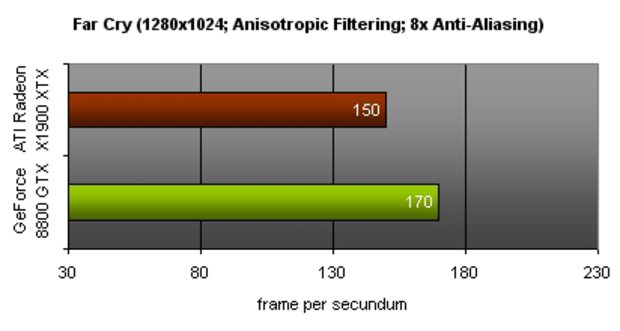

Far Cry (1280x1024; Anisotropic Filtering; 8x Anti-Aliasing)

Már több mint két éve annak, hogy a Far Cry boltokba került, s elkápráztatott minket: bizony, a játék gépigénye akkoriban olyan durvának bizonyult, hogy sokaknak nem volt lehetősége még csupán kipróbálni sem az anyagot. Másfelől a Far Cry anno mérföldkőnek számított, így nem hagyhattuk ki tesztjátékaink közül. G80-nal felszerelt kártyánk 170 fps-t produkált maximális beállítások mellett, míg az ATI-modell 150-et. A sebesség azonban nem minden! Érdekes volt megfigyelni, hogy az Nvidia kártyájával a játék egy halom bug volt: a föld elfeketedett, a képernyő kivilágosodott és így tovább – további finomság, hogy a GeForce 8800 nem csak e játéknál égett le: a Splinter Cell: Double Agent tesztje azért maradt ki felhozatalunkból, mert az új kártyával egy bughalmaznak tűnt szimplán a játék.

Ghost Recon: Advanced Warfighter (1280x1024; 16x AF)

Napjaink leggépigényesebb játéka a Ghost Recon 3, ez kétségtelen. A hatalmas, szabadon bejárható játékterület eszi az erőforrásokat, valamint a gyönyörű grafika is növeli a követelményeket. A játék minden effektjének megjelenítéséhez még Ageia PhysX gyorsítókártyára is szükség van, mely elképesztően brutális fizikával kápráztatja el a játékost – mi sajnos ezen kártya nélkül teszteltünk. Maximális beállítások mellett a játékkal semmi gondunk nem volt, az kitűnően szaladt, egy pillanatra sem szaggatott be. A GeForce-kártya esetében 90, míg a Radeonéban 70 fps-t mértünk futtatás közben. Eredményeink minden bizonnyal a PhysX-kártyával magasabb helyen végezték volna, hiszen e gyorsító a videokártya fölös terheit hivatott semlegesíteni. A játék kézikönyve szerint a tökéletes futtatáshoz nem árt egy Intel processzor egy ATI-kártya…

Hitman: Blood Money (1280x1024; 16x Anisotropic Filtering; 8x AA)

Következő áldozatunk a várva-várt Hitman: Blood Money volt, mely szintén Nvidia által támogatott cím. A sorozat történelmében a negyedik rész nemhogy a legszebb, de a legigényesebb is: gyengébb gépeken szinte el sem indul a játék, a menüben óriási szaggatásokat lehet tapasztalni, a játékmenet pedig egy diavetítéssel megegyező élményeket nyújt. Nem nagy meglepetésünkre a 8800 állta a próbát, s lazán futtatta a kényes címet, 60 fps-t produkálva közben. Az ATI-kártyával sem volt különösebb gondunk, ám ott az fps-szám „csak" 50 volt.

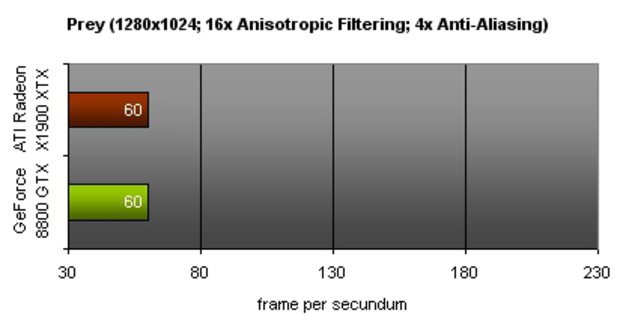

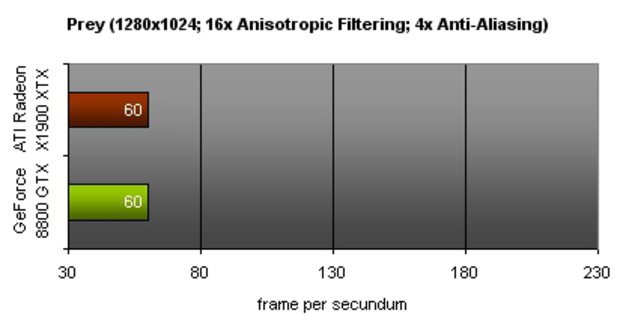

Prey (1280x1024; 16x Anisotropic Filtering; 4x Anti-Aliasing)

Ki akartunk próbálni mindenképpen egy Doom 3 Engine által hajtott játékot is, választásunk végül a Prey-re esett több ok miatt: ez a legfrissebb Doom 3-as játék, ez a legszebb és ez a legoptimalizáltabb. Nagy meglepetésünkre a két kártyával mért eredmények megegyeznek, az fps-szám stabilan 60 volt úgy, hogy a beállítások maximálisak voltak, valamint az anizotropikus szűrőt és az élsimítást is a lehető legjobbra állítottuk. Semmiféle szaggatást vagy bugot nem tapasztaltunk, bár valljuk be: a Prey nem számít annyira szépnek, hogy egy icipici beröccenést is megengedhessen magának két ilyen súlyos kártya mellett.

RoboBlitz (1280x1024)

Leginkább a RoboBlitz tesztet vártuk, hiszen a robotos akciójáték egyike az első Unreal 3.0 Engine által hajtott játékoknak, sőt PC-n az első olyan cím, melyet ezen motor hajt. A G80 itt szinte kétszer olyan jól teljesített, mint az ATI-modell – Ageia PhysX gyorsítókártya nélkül 230 fps-t mértünk vele, míg a Radeon X1900XTX 120 fps-t produkált. Bár a játék megkövetel magának egy kemény gépet, a komolyabb Unreal 3-as címek nyomába nem tud érni sem külsőleg, sem rendszerigényileg. Elég meglesni az X360-as Gears of Wart: földbe döngöli a RoboBlitzet – persze nem arról van szó, hogy csúnya játék lenne a Naked Sky üdvöskéje. Sőt! Mindenesetre igencsak előfutára még annak, amit az Unreal 3 nyújtani képes.

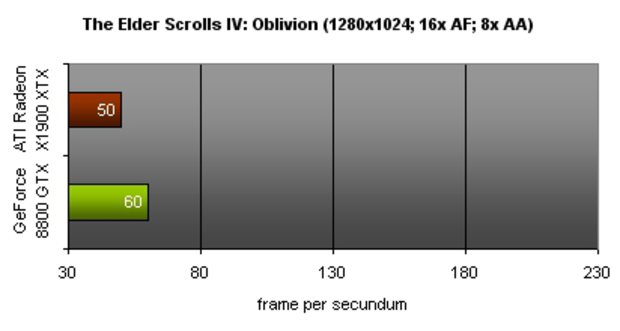

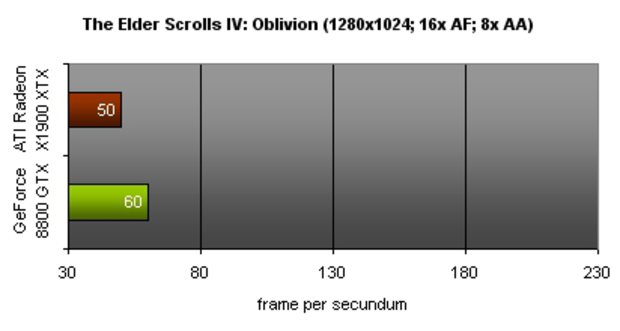

TES IV: Oblivion (1280x1024; 16x AF; 8x Anti-Aliasing)

A szerepjátékok jelenlegi királya komoly grafikával rendelkezik, ám ennek megvan az ára is. Az a gép, amit a játék alá kell tolni, hogy maximális részletesség mellett fusson, Pakson leledzik atomerőmű formájában. Mindenesetre tettünk egy próbát tesztrendszerünkkel a biztonság kedvéért, s lám: megérte. :) A lehető legjobb beállítások alatt a GeForce 8800 60 fps-t tudott felmutatni, míg a Radeon-kártya 50 képkockát jelenített meg másodpercenként. Mindeközben semmilyen szaggatást nem tapasztaltunk, teljesen meg voltunk elégedve a sebességgel.

A játéktesztek végére érve elmondhatjuk, hogy az új G80 meggyőzött minket. Elsősorban az újonnan kifejlesztett technológia az, ami miatt ajánlani tudjuk a kártyát, hiszen a jövő az új shader architektúrában van és a DirectX 10-ben. Egyelőre a kártya ára az, ami visszatarthatja a kedves olvasót a vásárlástól: a GeForce 8800 GTX nyugaton 599 dollárba (körülbelül 120 ezer forint), a 8800 GTS pedig 449 zöldhasúba (körülbelül 90 ezer forint) fáj. Tesztünkből lejöhetett az, hogy a technikai dolgokat nem igazán részleteztük: úgy gondoltuk, ez maradjon továbbra is nagytestvérünk, a HWSW feladata, mi inkább játékos szemszögből figyeljük meg a G80-at. Játékosokként viszont zárómondatként annyit mondhatunk: mivel jövőre megérkeznek az első DirectX 10-et támogató címek (Crysis, Halo 2), így a gyors tempó tartása végett érdemes lehet váltani, azonban egy rövid ideig nyugodtan várhatunk még – talán még jut időnk megvárni az ATI válaszát is az Nvidia újításaira. A teszthez biztosított alkatrészekért köszönet a Mikland Computer-nek (mikland.hu), az NVIDIA-nak (nvidia.com), Fierynek és a Ramiris Rubin-nak (ramiris.eu).

A G80 fejlesztésénél a hangsúly kétségtelenül a minél nagyobb kihasználtságra helyeződött, vagyis a készítők úgy tervezték meg az új processzort, hogy az mindig kihasználja az erőforrásokat, annak minden része együttesen, egyaránt dolgozzon – korábbi GPU-knál fordult elő, hogy míg például egyes shaderek kőkeményen dolgoztak, addig mások „pihentek" függően a megjelenített alkalmazástól. Az Nvidia által unified shader néven emlegetett architektúra lényegét dióhéjban a fentiekkel lehetne összefoglalni. Konkrétabban arról van szó, hogy a chipben nincsenek különálló vertex illetve pixel shaderek, hanem egységes stream processzorok vannak, melyek az előbbiek által végzett műveleteket is végre tudják hajtani. Lévén a végrehajtandó feladatok tömkelege a stream processzorokra együttesen hárul, mindennemű veszteség megszűnik gyakorlatilag. A chip 128 darab stream processzort tartalmaz, ezek 1350Mhz-en ketyegnek, összesen teljesítményük körülbelül 520 gigaflops. Úgy vélem, nekünk, játékosoknak felesleges ecsetelni, hogy mennyire komoly lehetőségekkel bír az új G80 néhány mostani és későbbi combos gépigényű játék szempontjából. Maga a GPU egyébként 575Mhz-en szalad, 681 millió tranzisztorból épül fel és 400 mm2 méretű, csíkszélessége pedig 90 nanométer. Érdekességként jegyezzük meg, hogy az Nvidia eddigi legjobbja, a G71 278 millió tranzisztorból épült fel csupán. Memóriatéren is erős a G80: a memória busz maga 384 bit, ez hat darab 64 bites csatornát jelent. A crossbar memóriavezérlőhöz 768Mb 900Mhz-es (valójában 1800Mhz) memória csatlakozik 86,4Gbps sávszélességgel.

Az Nvidia mérnökei a képminőségre is rágyúrtak a teljesítmény fokozása mellett, sikerült utolérni az ATI-t ezúton is. Elérhetővé vált az úgy nevezett Coverage Sampling Anti-Aliasing (CSAA), mely biztosítja azt, hogy a kártya felvehesse a kesztyűt élsimítás terén az ATI üdvöskéi ellen – mint tesztjeink során kiderült, a G80 állta a próbát, s mind képminőség, mind pediglen gyorsaság szempontjából olyat produkált, amilyet a legújabb Radeonok sem tudtak. További érdekesség, hogy a mostanság oly népszerű HDR (High Dynamic Range) grafikai opció bekapcsolható Anti-Aliasing mellett is, mely révén szemeinknek még nagyobb vizuális orgazmusban lesz része. Az anizotropikus szűrések terén is bizonyított anno az ATI, azonban az Nvidia-pártiaknak sem kell mostantól aggódniuk: a G80 ugyanis nem csupán beérte az újabb Radeonok által nyújtott fícsöröket itt is, de még rá is pakolt némi lóerőt azokra. A DirectX 10 a Windows Vista megvásárlása után elérhető ugyan, de kell is alá némi vas, hogy a benne rejlő lehetőségeket megfelelően kihasználhassuk – örömmel jelenthetjük, a G80-nal felszerelt GeForce 8800 az első olyan videokártya, mely támogatja is az új rendszert és tud is alá elég erőt biztosítani, hogy az komolyabban működhessen (természetesen nem kötelező majd egy 8800-erősségű kártya a használatához). Bár az első DirectX 10-es játékokra (például Crysis – megjelenés jövő év áprilisa után) még várni kell, addig is nem árt kielemezni miről is van szó lényegében. Gyakorlatilag teljesen újraírták a rendszert a Microsoftnál, ily módon például az overhead (adatátvitel miatti késleltetés) csökkenni fog. A távoljövőben csak azok a videokártyák támogatják majd a DirectX 10-et, melyek a már említett unified shader architektúrára épülnek. Megjelennek majd az úgy nevezett geometriai shaderek is, melyeknek a főprocesszor tehermentesítésében lesz nagy szerepük.

Ideje foglalkozni magának a kártyának a méreteivel is. Gondolom, mindent elárulok azzal, ha azt mondom: jelenleg a piacon nincs hatalmasabb kártya a GeForce 8800-nál. Hihetetlenül hosszú darabbal van dolgunk, melynek magassága is szemrevaló a szintén nagy ventilátor miatt. Daks kollégával hatalmasakat csodálkoztunk a kártya méretén, hiszen egy ekkora vas éppen belefért pár éves gépházunkba (kettőt-hármat rávertünk kalapáccsal – végül csak belepasszíroztuk :)). Tesztgépünket az Intel "Bad Axe 2" D975XBX2 típusú adatlapjára építettük, melybe a nemrégen megjelent négymagos Intel Core 2 Quad processzorok egyikét helyeztük 2*512 megabájt DDR2-es RAM társaságában. Az Nvidia GeForce 8800 GTX teljesítményét az ATI Radeon X1900XTX-ével hasonlítottuk össze, ami 512 megabájt memóriával van felszerelve. Az áramot egy jó minőségű, 550W-os táp szolgáltatta, hiszen új kártyánk annyit eszik, mint egy disznó – a GeForce 8800 kétszer annyi energiát kölcsönzött a tápegységen keresztül, mint a vízhűtéses ATI-csúcsmodell. A merevlemezre feltelepített Windows XP-nket csupán néhány driverrel, segédprogrammal és a tesztjátékokkal terheltük. Ezen címek egy részét magunk jelöltük ki, egy-kettőt pedig Ti választhattok meg: ezek többnyire új, felső kategóriás gépeket igénylő gammák, melyeket a legújabb motorok hajtanak – többek között megpróbálkoztunk az Unreal 3.0 Engine egy előfutárával is az érdekesség kedvéért. Lássuk hát, hogy milyen következtetéseket vontunk le a mérések után!

Battlefield 2 (1024x768; 8x Anti-Aliasing)

A sort az Electronic Arts tavaly nyári lövöldözős játékával nyitottuk. Biztosan sokatokban merült fel a kérdés, hogy miért nem az újonnan megjelent Battlefield 2142-n keresztül izzasztottuk le a kártyát: ennek viszonylag egyszerű oka, miután szerkesztőségünkbe még a kártya tesztelésekor nem érkezett meg a legújabb rész tesztverziója. Sebaj! Gondoltuk a srácokkal, s ezzel a lendülettel fogtuk a Battlefield 2 telepítőlemezét, majd felpakoltuk gépünkre a szintén gépigényes produktumot. A GeForce 8800 segítségével stabil 100 fps-t értünk el úgy, hogy eközben a legnagyobb pályákon játszottunk elképesztően sok játékos társaságában. Ugyanilyen helyzetben átlag 90 fps-t mértünk az ATI-kártya esetében: bár itt is sikerült elérni időnként a százas határt, azonban gyakran visszaesett a számláló, mely átlagolva gyengébb teljesítményt jelent.

Call of Duty 2 (1280x1024; Anisotropic Filtering; 4x Anti-Aliasing)

A piacon talán jelenleg a Call of Duty 2 a leggépigényesebb világháborús FPS – legalábbis a Medal of Honor: Airborne és a Brothers in Arms: Hell's Highway megjelenéséig biztosan. Az Infinity Ward lövöldözős címe azért is érdekelt minket, mert Nvidia által támogatott játékról van szó: kíváncsiak voltunk tehát, hogy vajh mennyit számít az, ha egyes hardvercégek odabiggyeszttetik emblémájukat egy-egy játék dobozára. A GeForce-kártya mérésekor 60 fps-t kaptunk eredményül, míg a Radeon 50 fps-en vizsgázott. A húsz százalékos teljesítménykülönbség azonban csak a kártyákra fogható, méréseredményeink nem függhettek a Nvidia-reklámtól, ily módon nem érdemes hinni az efféle marketingnek.

Dark Messiah of M&M (1280x1024; 16x AF; 8x Anti-Aliasing)

Az Arkane Studios által fejlesztett akció-szerepjáték nevezhető akár a lehetőségek játékának is: szinte minden létező effektet bekapcsolhatunk benne, az eredmény pedig bámulatos – a továbbfejlesztett Source engine elképesztő minőségben nyilvánul meg. A GeForce 8800 GTX 60 fps-en futtatta a játékot, míg a Radon X1900XTX átlag 45 fps-en: elérte ugyan a hatvanas számot ő is, mi azonban átlagot számoltunk, mely jóval alacsonyabb teljesítményt jelent. Érdekesség, hogy bár a Dark Messiah of Might & Magic Nvidia által támogatott a játék, ennek ellenére a G80-nal felépített konfiguráción időnként rövid időkre csúnyán beröccent - ilyet az ATI-kártyával történő tesztelés során nem tapasztaltunk.

F.E.A.R. (1024x768)

A nemrégen kiegészült F.E.A.R. szintén megkövetelte magának az erős gépet, tavalyi megjelenésekor ámultunk mind a cím grafikáján, mind a rendszerigényén: horrorjáték lévén, a F.E.A.R. igazán fény- és árnyékeffektek terén erős, hiszen egy efféle játéknál nincs is fontosabb hangulati elem a félhomálynál, a sötétségnél és a sejtelmes fényforrásoknál. Az Nvidia által támogatott F.E.A.R. 60 fps-en teljesített az Nvidia-kártyával, míg az ATI-csúcsmodell 45 fps-t ért el. Valószínűleg a mi készülékünkben volt a hiba, de mindkét kártyával időnként nagyon csúnyán beszaggatott a játék, ami miatt olykor játszhatatlanná is vált a Monolith lövöldözőse: nem igazán tudtuk el eldönteni, hogy vajon mi tett keresztbe a tesztelésnek a kártyákon kívül – a négymagos processzor vagy az egy gigányi RAM? :)

Far Cry (1280x1024; Anisotropic Filtering; 8x Anti-Aliasing)

Már több mint két éve annak, hogy a Far Cry boltokba került, s elkápráztatott minket: bizony, a játék gépigénye akkoriban olyan durvának bizonyult, hogy sokaknak nem volt lehetősége még csupán kipróbálni sem az anyagot. Másfelől a Far Cry anno mérföldkőnek számított, így nem hagyhattuk ki tesztjátékaink közül. G80-nal felszerelt kártyánk 170 fps-t produkált maximális beállítások mellett, míg az ATI-modell 150-et. A sebesség azonban nem minden! Érdekes volt megfigyelni, hogy az Nvidia kártyájával a játék egy halom bug volt: a föld elfeketedett, a képernyő kivilágosodott és így tovább – további finomság, hogy a GeForce 8800 nem csak e játéknál égett le: a Splinter Cell: Double Agent tesztje azért maradt ki felhozatalunkból, mert az új kártyával egy bughalmaznak tűnt szimplán a játék.

Ghost Recon: Advanced Warfighter (1280x1024; 16x AF)

Napjaink leggépigényesebb játéka a Ghost Recon 3, ez kétségtelen. A hatalmas, szabadon bejárható játékterület eszi az erőforrásokat, valamint a gyönyörű grafika is növeli a követelményeket. A játék minden effektjének megjelenítéséhez még Ageia PhysX gyorsítókártyára is szükség van, mely elképesztően brutális fizikával kápráztatja el a játékost – mi sajnos ezen kártya nélkül teszteltünk. Maximális beállítások mellett a játékkal semmi gondunk nem volt, az kitűnően szaladt, egy pillanatra sem szaggatott be. A GeForce-kártya esetében 90, míg a Radeonéban 70 fps-t mértünk futtatás közben. Eredményeink minden bizonnyal a PhysX-kártyával magasabb helyen végezték volna, hiszen e gyorsító a videokártya fölös terheit hivatott semlegesíteni. A játék kézikönyve szerint a tökéletes futtatáshoz nem árt egy Intel processzor egy ATI-kártya…

Hitman: Blood Money (1280x1024; 16x Anisotropic Filtering; 8x AA)

Következő áldozatunk a várva-várt Hitman: Blood Money volt, mely szintén Nvidia által támogatott cím. A sorozat történelmében a negyedik rész nemhogy a legszebb, de a legigényesebb is: gyengébb gépeken szinte el sem indul a játék, a menüben óriási szaggatásokat lehet tapasztalni, a játékmenet pedig egy diavetítéssel megegyező élményeket nyújt. Nem nagy meglepetésünkre a 8800 állta a próbát, s lazán futtatta a kényes címet, 60 fps-t produkálva közben. Az ATI-kártyával sem volt különösebb gondunk, ám ott az fps-szám „csak" 50 volt.

Prey (1280x1024; 16x Anisotropic Filtering; 4x Anti-Aliasing)

Ki akartunk próbálni mindenképpen egy Doom 3 Engine által hajtott játékot is, választásunk végül a Prey-re esett több ok miatt: ez a legfrissebb Doom 3-as játék, ez a legszebb és ez a legoptimalizáltabb. Nagy meglepetésünkre a két kártyával mért eredmények megegyeznek, az fps-szám stabilan 60 volt úgy, hogy a beállítások maximálisak voltak, valamint az anizotropikus szűrőt és az élsimítást is a lehető legjobbra állítottuk. Semmiféle szaggatást vagy bugot nem tapasztaltunk, bár valljuk be: a Prey nem számít annyira szépnek, hogy egy icipici beröccenést is megengedhessen magának két ilyen súlyos kártya mellett.

RoboBlitz (1280x1024)

Leginkább a RoboBlitz tesztet vártuk, hiszen a robotos akciójáték egyike az első Unreal 3.0 Engine által hajtott játékoknak, sőt PC-n az első olyan cím, melyet ezen motor hajt. A G80 itt szinte kétszer olyan jól teljesített, mint az ATI-modell – Ageia PhysX gyorsítókártya nélkül 230 fps-t mértünk vele, míg a Radeon X1900XTX 120 fps-t produkált. Bár a játék megkövetel magának egy kemény gépet, a komolyabb Unreal 3-as címek nyomába nem tud érni sem külsőleg, sem rendszerigényileg. Elég meglesni az X360-as Gears of Wart: földbe döngöli a RoboBlitzet – persze nem arról van szó, hogy csúnya játék lenne a Naked Sky üdvöskéje. Sőt! Mindenesetre igencsak előfutára még annak, amit az Unreal 3 nyújtani képes.

TES IV: Oblivion (1280x1024; 16x AF; 8x Anti-Aliasing)

A szerepjátékok jelenlegi királya komoly grafikával rendelkezik, ám ennek megvan az ára is. Az a gép, amit a játék alá kell tolni, hogy maximális részletesség mellett fusson, Pakson leledzik atomerőmű formájában. Mindenesetre tettünk egy próbát tesztrendszerünkkel a biztonság kedvéért, s lám: megérte. :) A lehető legjobb beállítások alatt a GeForce 8800 60 fps-t tudott felmutatni, míg a Radeon-kártya 50 képkockát jelenített meg másodpercenként. Mindeközben semmilyen szaggatást nem tapasztaltunk, teljesen meg voltunk elégedve a sebességgel.

A játéktesztek végére érve elmondhatjuk, hogy az új G80 meggyőzött minket. Elsősorban az újonnan kifejlesztett technológia az, ami miatt ajánlani tudjuk a kártyát, hiszen a jövő az új shader architektúrában van és a DirectX 10-ben. Egyelőre a kártya ára az, ami visszatarthatja a kedves olvasót a vásárlástól: a GeForce 8800 GTX nyugaton 599 dollárba (körülbelül 120 ezer forint), a 8800 GTS pedig 449 zöldhasúba (körülbelül 90 ezer forint) fáj. Tesztünkből lejöhetett az, hogy a technikai dolgokat nem igazán részleteztük: úgy gondoltuk, ez maradjon továbbra is nagytestvérünk, a HWSW feladata, mi inkább játékos szemszögből figyeljük meg a G80-at. Játékosokként viszont zárómondatként annyit mondhatunk: mivel jövőre megérkeznek az első DirectX 10-et támogató címek (Crysis, Halo 2), így a gyors tempó tartása végett érdemes lehet váltani, azonban egy rövid ideig nyugodtan várhatunk még – talán még jut időnk megvárni az ATI válaszát is az Nvidia újításaira. A teszthez biztosított alkatrészekért köszönet a Mikland Computer-nek (mikland.hu), az NVIDIA-nak (nvidia.com), Fierynek és a Ramiris Rubin-nak (ramiris.eu).

Kapcsolódó cikkek

Ha nem vagy még tag, regisztrálj! 2 perc az egész.